Due mesi dopo Nvidia e OpenAI hanno svelato le loro strabilianti qualità prevede di implementare almeno 10 gigawatt di sistemi Nvidia e fino a 100 miliardi di dollari di investimenti: il produttore di chip ora ammette che l’accordo non è effettivamente definitivo.

Intervenendo martedì alla Global Technology and AI Conference di UBS a Scottsdale, in Arizona, l’EVP e CFO di Nvidia Colette Kress ha detto agli investitori che la tanto pubblicizzata partnership OpenAI è ancora in fase di lettera di intenti.

“Non abbiamo ancora concluso un accordo definitivo”, ha detto Kress quando gli è stato chiesto quanto dell’impegno di 10 gigawatt sia effettivamente bloccato.

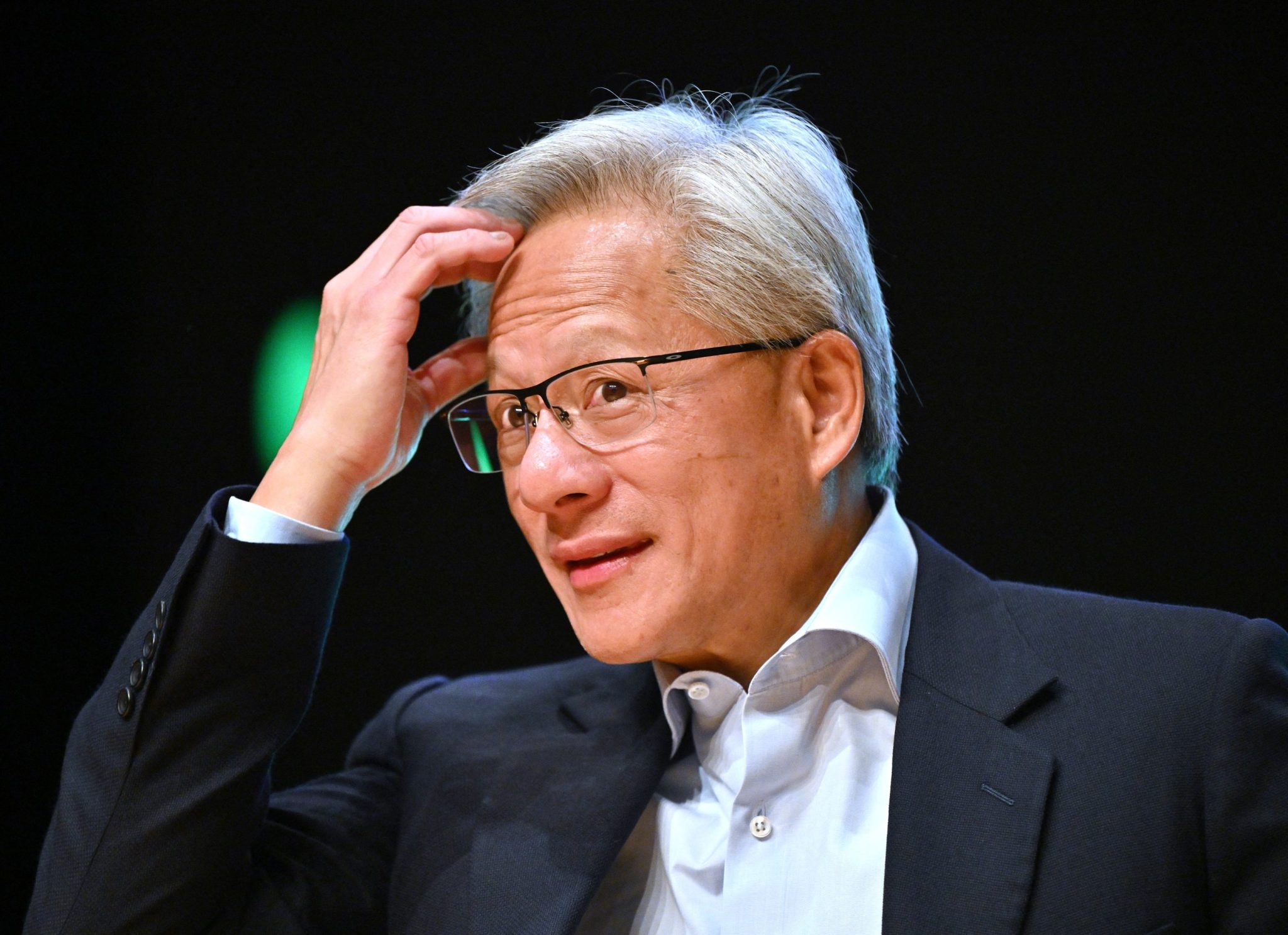

Questo è un chiarimento sorprendente per un accordo che una volta il CEO di Nvidia Jensen Huang chiamato “il più grande progetto di infrastruttura AI della storia”. Gli analisti avevano stimato che l’affare potrebbe generare fino a 500 miliardi di dollari di entrate per il produttore di chip AI.

Quando le aziende hanno annunciato la partnership a settembre, hanno delineato un piano per implementare milioni di GPU Nvidia nell’arco di diversi anni, supportate da un massimo di 10 gigawatt di capacità del data center. Nvidia si è impegnata a investire fino a 100 miliardi di dollari in OpenAI non appena ogni tranche sarà online. La notizia ha aiutato alimentare un rally delle infrastrutture IA, facendo salire le azioni di Nvidia del 4% e rafforzando la narrazione secondo cui le due società sono unite.

I commenti di Kress suggeriscono qualcosa di più provvisorio, anche mesi dopo il rilascio del quadro.

Un mega affare che non è ancora nei numeri

Non è chiaro il motivo per cui l’accordo non è stato concluso, ma l’ultimo 10-Q di Nvidia offre degli indizi. IL archiviazione afferma chiaramente che “non vi è alcuna garanzia che qualsiasi investimento sarà completato nei termini previsti, se non del tutto”, riferendosi non solo all’accordo OpenAI ma anche all’investimento pianificato di 10 miliardi di dollari da parte di Nvidia in Anthropic e al suo impegno di 5 miliardi di dollari per Intel.

In una lunga sezione “Fattori di rischio”, Nvidia spiega la fragile architettura alla base di mega affari come questo. L’azienda sottolinea che la storia è reale tanto quanto la capacità del mondo di costruire e alimentare i data center necessari per far funzionare i propri sistemi. Nvidia deve ordinare GPU, memoria HBM, apparecchiature di rete e altri componenti con più di un anno di anticipo, spesso tramite contratti prepagati non cancellabili. Se i clienti ridimensionano, ritardano il finanziamento o cambiano direzione, Nvidia avverte che potrebbero ritrovarsi con “inventario in eccesso”, “penali di cancellazione” o “accantonamenti o menomazioni di inventario”. Le passate discrepanze tra domanda e offerta hanno “danneggiato in modo significativo i nostri risultati finanziari”, si legge nelle note del deposito.

Il più grande fattore di oscillazione sembra essere il mondo fisico: Nvidia afferma che la disponibilità di “capacità, energia e capitale del data center” è fondamentale affinché i clienti possano implementare i sistemi di intelligenza artificiale a cui si sono impegnati verbalmente. L’accumulo di energia è descritto come un “processo pluriennale” che affronta “sfide normative, tecniche e di costruzione”. Se i clienti non riescono a garantire energia elettrica o finanziamenti sufficienti, avverte Nvidia, ciò potrebbe “ritardare l’implementazione da parte dei clienti o ridurre la portata” dell’adozione dell’intelligenza artificiale.

Nvidia ammette anche che il proprio ritmo di innovazione rende la pianificazione più difficile. Si è passati a una cadenza annuale di nuove architetture – Hopper, Blackwell, Vera Rubin – pur continuando a supportare le generazioni precedenti. Si rileva che un ritmo di architettura più rapido “potrebbe amplificare le sfide” della previsione della domanda e può portare a “una domanda ridotta per i prodotti della generazione attuale”.

Queste ammissioni fanno cenno agli avvertimenti degli orsi dell’intelligenza artificiale come Michael Burry, l’investitore famoso per “la grande scommessa”, che ha affermato che Nvidia e altri produttori di chip stanno estendendo eccessivamente la vita utile dei loro chip e che l’eventuale deprezzamento dei chip causerà interruzioni nel ciclo di investimento. Tuttavia, Huang lo ha detto patatine di sei anni fa corrono ancora a pieno ritmo.

L’azienda ha anche fatto cenno esplicitamente ai cicli di boom-bust del passato legati a casi d’uso “di tendenza” come il crypto mining, avvertendo che i nuovi carichi di lavoro dell’intelligenza artificiale potrebbero creare picchi e arresti anomali simili difficili da prevedere e che potrebbero inondare il mercato grigio con GPU di seconda mano.

Nonostante la mancanza di un accordo, Kress ha sottolineato che il rapporto di Nvidia con OpenAI rimane “una partnership molto forte”, vecchia di più di un decennio. OpenAI, ha affermato, considera Nvidia il suo “partner preferito” per l’elaborazione. Ma ha aggiunto che le attuali prospettive di vendita di Nvidia non si basano sul nuovo mega accordo.

La richiesta di circa 500 miliardi di dollari di sistemi Blackwell e Vera Rubin che Nvidia ha guidato per il 2025-2026 “non include nulla del lavoro che stiamo svolgendo in questo momento sulla parte successiva dell’accordo con OpenAI”, ha affermato. Per ora, gli acquisti di OpenAI fluiscono indirettamente attraverso partner cloud come Microsoft E Oracolo piuttosto che attraverso il nuovo accordo diretto previsto nella LOI.

OpenAI “vuole andare direttamente”, ha detto Kress. “Ma ancora una volta, stiamo ancora lavorando a un accordo definitivo”.

Nvidia insiste che il fossato sia intatto

Sulle dinamiche competitive, Kress è stato inequivocabile. I mercati ultimamente hanno applaudito il TPU di Google – che ha un caso d’uso più piccolo della GPU ma richiede meno energia – come potenziale concorrente della GPU di NVIDIA. Alla domanda se questi tipi di chip, chiamati ASICS, stiano riducendo il vantaggio di Nvidia, ha risposto: “Assolutamente no”.

“Il nostro obiettivo in questo momento è aiutare tutti i diversi costruttori di modelli, ma anche aiutare tante aziende con uno stack completo”, ha affermato. Il fossato difensivo di Nvidia, ha sostenuto, non è un singolo chip ma l’intera piattaforma: hardware, CUDA e una libreria in costante espansione di software specifici del settore. Questo stack, ha detto, è il motivo per cui le architetture più vecchie rimangono ampiamente utilizzate anche se Blackwell diventa il nuovo standard.

“Tutti sono sulla nostra piattaforma”, ha detto Kress. “Tutti i modelli sono sulla nostra piattaforma, sia nel cloud che on-premise.”